#8 创建Robots.txt文件

与生活中的任何事情一样,需要规则来控制主要问题。对于网站,必须创建一个Robots.txt文件,其中有一些规则供搜索引擎遵循。

要为网站创建一个robots.txt文件,请遵循以下步骤。

1- 检查现有的robots.txt文件

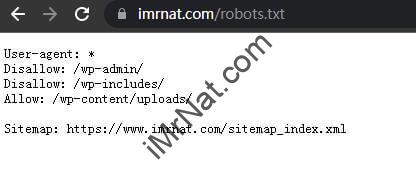

通常,每个安装的WordPress都带有一个默认的WordPress robots.txt。发现这个默认的robots.txt文件是为了防止搜索引擎爬行到管理文件夹中。 可以通过在浏览器中输入 “yourdomainname.com/robots.txt “来查看Robots.txt。

该页面将显示为这样。

是的,它看起来很愚蠢,但这个robots.txt文件就是这么简单。

2- 用自己的规则创建一个robots.txt文件

为了设置自己的规则,我们将学习如何创建一个robots.txt文件。

可以通过以下步骤简单地做到这一点。

用记事本或notepad+++创建一个新的.txt文件。

通过输入 “User-agent*”开始 robots.txt 文件。(实际上,所有 robots.txt 都以这一行开始)。

3- 设置规则

我们都知道,创建robot.txt文件的作用是设置你自己的规则。可能的规则是。

阻止一个特定的路径/文件夹

输入 “Disallow: /your-path”。

写下想阻止的路径/文件夹名,而不是 “your-path”。

有了这一行,就会阻止这个路径和其他所有通过它的路径。

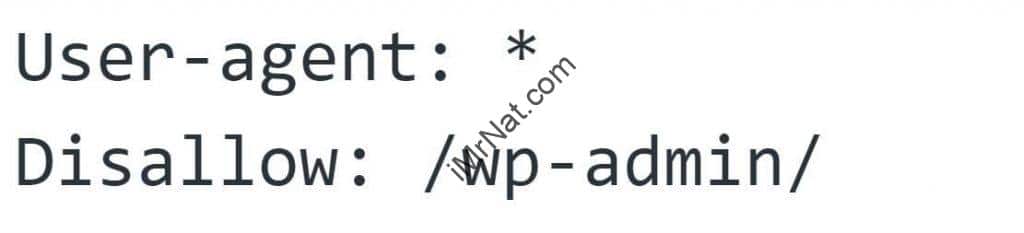

例如:我并不想搜索引擎收录我WordPress网站的admin文件夹,则写法规则如下:“disallow: /wp-admin/”

阻止一个文件类型。

输入 “disallow: /*.filetype$”。

写下想阻止的文件类型的名称,而不是 “filetype”。

如果写 “disallow: /*jpg$,将阻止爬虫访您网站上的所有jpg文件。

此外,如果想阻止爬虫访问某个文件,请写下它的名字,而不是 “*”,例如。”Imagename.jpg”。

允许爬虫访问特定的子路径

输入 “allow: /yourpath/sub-path”。

写下想允许爬虫访问的路径,而不是 “yourpath/sub-path”。

比方说,想阻止对wp-content文件夹的访问,但允许对wp-content下面uploads文件的访问,那么应该写上两行这样的话。

“User-agent: *

disallow: /wp-content/

allow: /wp-content/uploads/”

允许爬虫访问特定的文件类型

输入 “allow: /*.filetype$”。

写上想允许爬虫访问的文件类型的名称,而不是 “filetype”。

阻止特定爬虫抓取网站

要阻止某些爬虫,只需在robots.txt文件的现有行下添加2个新行。

• “User-agent: Unwanted Crawler”

• “Disallow: /”

注意。

在创建或编辑任何 robots.txt 文件后,必须保存它。

4- 添加 robots.txt 文件

可以使用几种方式添加 robots.txt 文件,包括。

通过FTP或SFTP

如果使用任何平台,只需要通过FTP或SFTP将robots.txt文件上传到网站的根目录。

通常,这需要一些开发知识和对服务器的访问。 因此,可以请开发人员帮助我们完成,以避免任何稳定性问题。

使用Yoast插件创建和添加robots.txt文件

如果你也和我一样使用的是WordPress,可以在Yoast插件的帮助下轻松完成。遵循这些步骤。

登录到WordPress仪表板。

在左边的菜单上,选择 “SEO”,然后选择工具。

在工具部分,选择 “文件编辑器”,然后选择 “创建 robots.txt 文件”。

注意,Yoast SEO不考虑默认的robots.txt文件。因此,如果没有robots.txt文件,会看到一条信息,说没有这个文件,我们就需要新建一个robots.txt。 一个TXT文件编辑器将打开,必须根据我们的规则来编辑。

像我们上面提到的那样,编写自己的规则,并确保与网站网站地图一起添加一行,以方便抓取所有的子页面。

规则:不允许wp-admin,wp-includes 和wp-content三个文件夹,允许wp-content文件夹里面的uploads文件夹。

最终robots.txt如下:

- User-agent: *

- Disallow: /wp-admin/

- Disallow: /wp-includes/

- Disallow: /wp-content/

- Allow: /wp-content/uploads/

- Sitemap: https://www.imrnat.com/sitemap_index.xml

祝贺! 到了这里你也和我一样已经完成了。只需点击 “保存对 robots.txt 的修改”。

Nat H.

扫我,直接撩